“Deepfake”, o embuste supremo

“Deepfake”, o embuste supremo

Se a manipulação de factos é, de uma forma ou de outra, tão antiga quanto a própria civilização, é inegável que a Internet veio abrir todo um novo leque de possibilidades neste campo. À boleia do boom das “fake news” (notícias falsas), que ameaçam a própria democracia, surgiu, nos últimos anos, uma forma ainda mais refinada de manipular a realidade: o “deepfake”. No fundo, é uma forma de pôr qualquer pessoa – ainda que as personalidades mediáticas sejam as mais visadas – a dizer o que nunca disse ou a fazer o que nunca fez, com um realismo tal que, para o comum dos mortais, se torna quase impossível detetar o embuste.

Como é feito

O “deepfake” resulta da síntese de imagens e sons humanos, a partir de técnicas de inteligência artificial. Pode ser usado para trocar o rosto de pessoas em vídeos ou até para sincronizar movimentos labiais, expressões faciais e outros detalhes, de forma a que o produto final seja o mais verosímil possível. Apesar de não ser um fenómeno novo, conheceu um “empurrão” importante em 2017, quando um utilizador do Reddit (rede social e agregador de notícias) criou um algoritmo que permite mapear o rosto de uma pessoa no corpo de outra, frame por frame. O software precisa apenas de uma fonte para reconhecer o rosto da pessoa visada, conseguindo, a partir daí, ajustar a movimentação do vídeo original ao novo rosto.

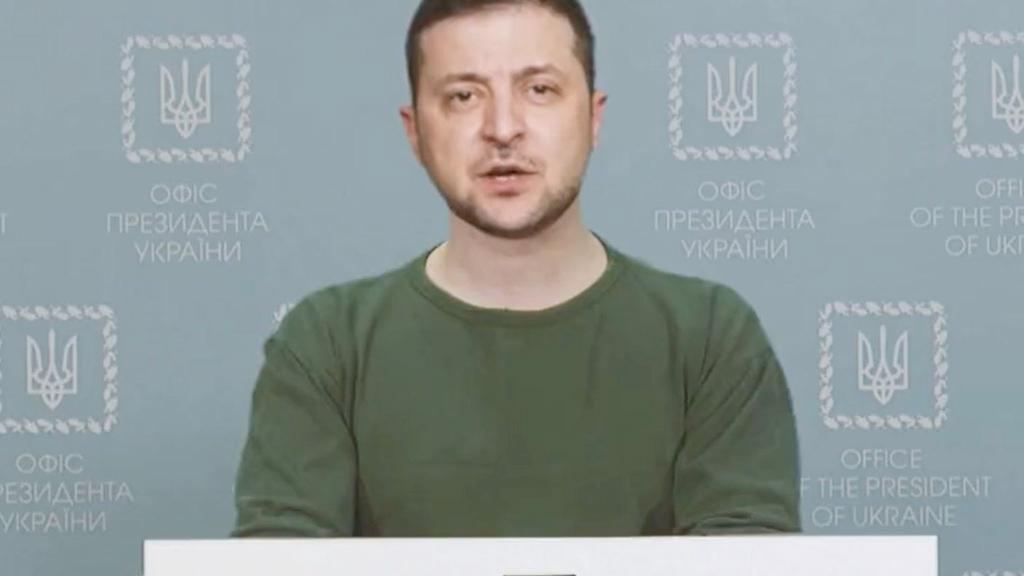

Super-heróis, Zelensky, Obama

Entre os “deepfakes” que se tornaram famosos, há uns quantos que recriam filmes ou cenas épicas do cinema, numa versão “renovada”. Desde uma cena da trilogia “Back to the future” em que Marty McFly e Doc Emmett Brown se transformam no Homem-Aranha e no Homem de Ferro a um “take” do Star Trek em que os protagonistas são Elon Musk e Jeff Bezos (há muitos mais exemplos). Mas também há casos mais preocupantes, com figuras emblemáticas da política mundial, como o vídeo em que Volodymyr Zelensky, presidente da Ucrânia, surge a assumir uma falsa rendição às tropas russas. Ou de a uma pivô brasileira, a anunciar alegadas sondagens, totalmente adulteradas. É ainda possível criar falsos vídeos de carácter sexual de celebridades ou de qualquer outra pessoa. Por mera vingança, por exemplo.

Apesar de as técnicas de “deepfake” estarem hoje cada vez mais apuradas, há certos cuidados que podes ter para não seres enganado. Desde logo, se receberes um vídeo duvidoso, deves vê-lo várias vezes, em várias velocidades. Isso vai ajudar a que possas identificar falhas. O rosto também é uma parte importante da equação. Pele, olhos, sobrancelhas, boca, todos estes detalhes podem ajudar a identificar o engodo. Há ainda outros dois passos que te podem ajudar: por um lado, procurar saber mais sobre aquele conteúdo, sempre em sites de informação credíveis; por outro, recorrer a ferramentas de inteligência artificial gratuitas, como o TensorFlow e o PyTorch, que ajudam a detetar os “deepfakes”.